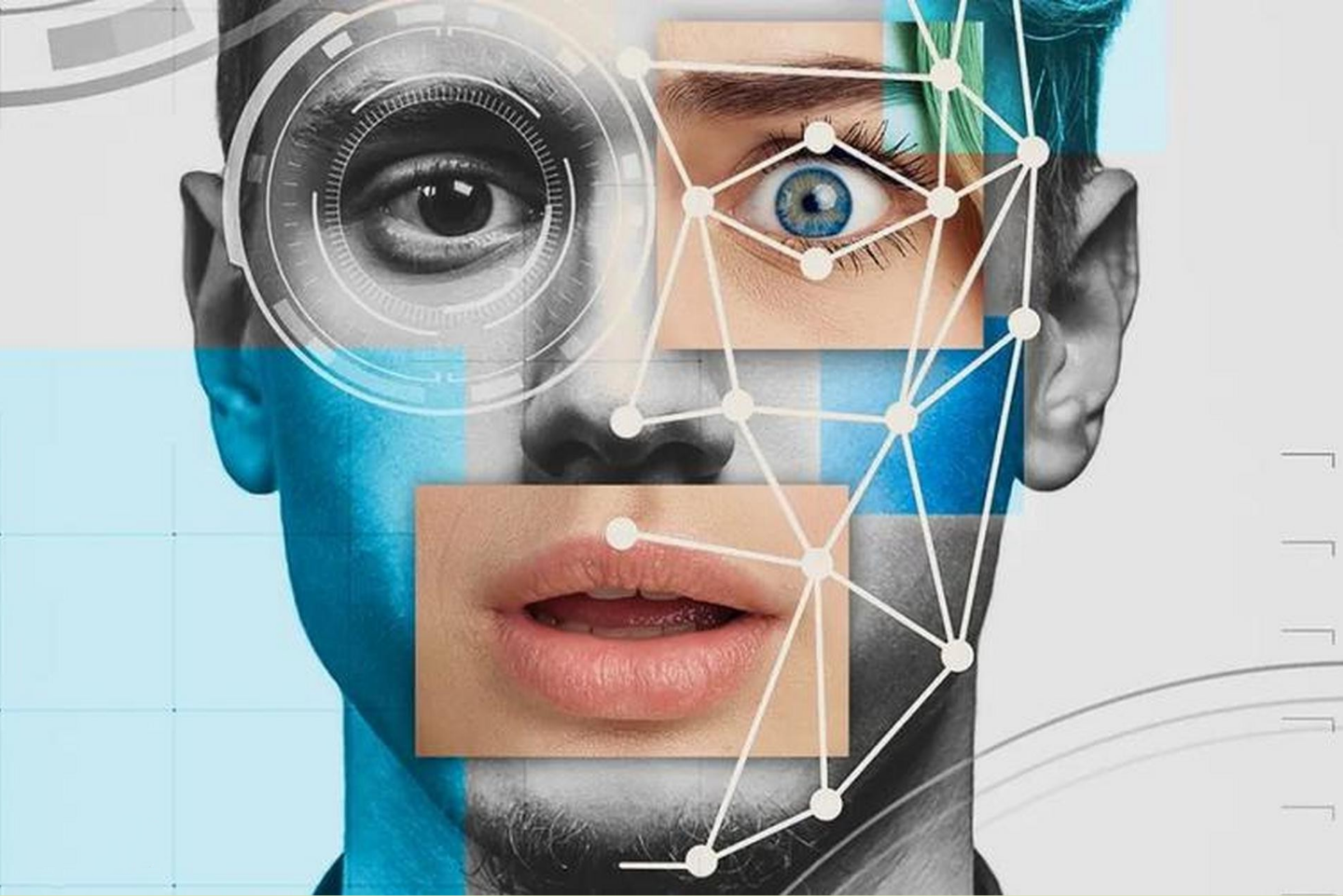

Технологии искусственного интеллекта открыли новую эпоху — эпоху симуляций. С помощью нейросетей можно не просто имитировать речь, лицо и мимику конкретного человека, а создавать реалистичные цифровые копии, способные «говорить» и «действовать» от его имени. Deepfake больше не воспринимается как безобидная забава: он стал инструментом давления, дискредитации и манипуляции. И если еще несколько лет назад это было темой технологических форумов, сегодня это — вызов судебной системе и праву личности.

Юристы больше не могут рассматривать изображение, видео или голос как бесспорное доказательство. Технологическая возможность создать идеальную подделку разрушила традиционную презумпцию достоверности например, в США принят законопроект AB 621, направленный против сервисов, создающих и распространяющих изображения с использованием лица человека без его разрешения, — еще одно свидетельство того, что deepfake постепенно становится предметом самостоятельного правового регулирования.

В судах разных стран уже рассматриваются дела, где deepfake становится инструментом давления и разрушения репутации. Так, в Калифорнии прокуратура Сан-Франциско подала иск против 16 сайтов, создававших non-consensual deepfake-порнографию. В результате разбирательства десять из них были закрыты, а суд признал подобные действия нарушением права на изображение и достоинство личности. В Южной Корее, после череды скандалов с поддельными видео и изображениями известных женщин, парламент ужесточил уголовную ответственность: теперь даже просмотр или хранение deepfake-порнографии без согласия лица наказывается лишением свободы до трех лет или штрафом до 30 млн вон. Эти прецеденты демонстрируют: право вынуждено реагировать постфактум — уже после разрушения репутации и достоинства. Но если тенденция не будет переломлена, суду скоро придется решать не только, кто прав, но и где действительность, а где сгенерированная симуляция.

Главная угроза не только в репутационных рисках, но и в кризисе доверия к доказательствам. Если любое видео можно сгенерировать, где гарантия, что суд не рассматривает симуляцию? Для правосудия это системный риск: когда подделка становится неотличимой от оригинала, рушится фундамент — принцип объективности. В ответ на это некоторые юрисдикции уже вводят цифровые водяные знаки, блокчейн-верификацию и судебную экспертизу ИИ-контента. Но универсального механизма нет.

Мировая практика пытается действовать на опережение. В США принят DEEPFAKES Accountability Act, устанавливающий обязанность маркировать синтетический контент и уголовную ответственность за распространение подделок без уведомления. В Европейском союзе AI Act (2024) закрепляет обязанность операторов ИИ-систем информировать пользователя о факте генерации контента, а GDPR относит биометрические данные — включая лицо и голос — к категории особо чувствительных. Южная Корея, как одна из технологических держав, прямо включила создание deepfake-видео без согласия в состав уголовных преступлений. Таким образом, цифровая идентичность человека постепенно становится объектом охраны права.

В Узбекистане эта тема также входит в законодательную повестку. 13 августа 2025 года Законодательная палата Олий Мажлиса приняла в третьем чтении закон «О правовом регулировании искусственного интеллекта». Документ пока находится на стадии рассмотрения в Сенате, а его полный текст не опубликован в открытом доступе. Известно, что проект определяет понятие «искусственный интеллект», закрепляет принципы государственной политики в этой сфере и устанавливает компетенцию государственного органа, ответственного за развитие и использование ИИ. Особое внимание, согласно официальным сообщениям, уделяется защите прав личности от возможных рисков, связанных с применением алгоритмических технологий.

Особое значение имеет норма, запрещающая принимать решения, затрагивающие права и свободы граждан, исключительно на основании выводов ИИ-систем. Это юридическое признание того, что алгоритм не может заменить человеческое суждение — особенно там, где на кону честь, репутация или правовой статус. Закон также вводит административную ответственность за незаконную обработку персональных данных с использованием ИИ и за их распространение в интернете или СМИ. Таким образом, Узбекистан делает первый шаг к тому, чтобы встроить защиту личности в цифровое законодательство.

Однако с точки зрения цифрового права, этот шаг — лишь начало. Закон регулирует создание и эксплуатацию ИИ-систем, но не охватывает случаи симуляции личности: создание голосовых или визуальных копий без согласия, deepfake-контент, подмену личности в сетевых коммуникациях. Здесь остается пробел: цифровая идентичность гражданина — его лицо, голос, манера речи — не имеет чётко определённого правового статуса. А значит, пока невозможно однозначно квалифицировать действия по созданию “ИИ-двойника” без разрешения как правонарушение.

С юридической точки зрения, проблема требует признания нового права — права на цифровую подлинность. Оно должно включать:

– запрет на создание и распространение цифровых симуляций личности без согласия;

– процедуру установления подлинности цифровых доказательств;

– механизм привлечения к ответственности за подмену личности в виртуальной среде.

Без этих норм цифровая свобода неизбежно превращается в цифровую уязвимость. Технологии искусственного интеллекта могут стать инструментом гуманизации, если их развитие будет идти в рамках права, которое сохраняет человека как центр — не алгоритм, не код, а личность. Иначе симуляции вытеснят саму реальность, а суд, медиа и общество останутся без главного ориентира — доверия к фактам.

Проект Uzbekistan Digital Rights Media Initiative (UDRMI) реализуется Центром развития современной журналистики (MJDC) в партнёрстве с Legal Policy Research Centre (LPRC) при финансовой поддержке Европейского союза (EU).